Deming-Regression

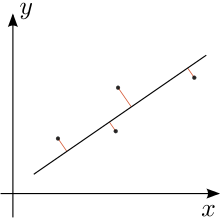

In der Statistik wird mit der Deming-Regression eine Ausgleichsgerade für eine endliche Menge metrisch skalierter Datenpaare () nach der Methode der kleinsten Quadrate bestimmt. Es handelt sich um eine Variante der linearen Regression. Bei der Deming-Regression werden die Residuen (Messfehler) sowohl für die - als auch für die -Werte in das Modell einbezogen.

Die Deming-Regression ist somit ein Spezialfall der Regressionsanalyse; sie beruht auf einer Maximum-Likelihood-Schätzung der Regressionsparameter, bei der die Residuen beider Variablen als unabhängig und normalverteilt angenommen werden und der Quotient ihrer Varianzen als bekannt unterstellt wird.

Die Deming-Regression geht auf eine Arbeit von C.H. Kummell (1879) zurück;[1] 1937 wurde die Methode von T.C. Koopmans wieder aufgegriffen[2] und in allgemeinerem Rahmen 1943 von W. E. Deming für technische und ökonomische Anwendungen bekannt gemacht.[3]

Die orthogonale Regression ist ein wichtiger Spezialfall der Deming-Regression; sie behandelt den Fall . Die Deming-Regression wiederum ist ein Spezialfall der York-Regression.

Rechenweg

BearbeitenDie gemessenen Werte und werden als Summen der „wahren Werte“ bzw. und der „Fehler“ bzw. aufgefasst, d. h. Die Datenpaare ( ) liegen auf der zu berechnenden Geraden. und seien unabhängig mit und . Bekannt sei zumindest der Quotient der Fehlervarianzen .

Es wird eine Gerade

gesucht, die die gewichtete Residuenquadratsumme minimiert:

Für die weitere Rechnung werden die folgenden Hilfswerte benötigt:

- (arithmetisches Mittel der )

- (arithmetisches Mittel der )

- (Stichprobenvarianz der )

- (Stichprobenvarianz der )

- (Stichprobenkovarianz der ).

Damit ergeben sich die Parameter zur Lösung des Minimierungsproblems:[4]

- .

Die -Koordinaten berechnet man mit

- .

Erweiterung York-Regression

BearbeitenYork-Regression erweitert die Deming-Regression, da es korrelierte x- und y-Fehler erlaubt[5].

Einzelnachweise

Bearbeiten- ↑ Charles H. Kummell: Reduction of observation equations which contain more than one observed quantity. In: The Analyst. Band 6, Nummer 4, 1879, S. 97–105, JSTOR:2635646.

- ↑ Tjalling Koopmans: Linear regression analysis of economic time series (= Publications of the Netherland Economic Institute. 20). De Erven F. Bohn, Haarlem 1937.

- ↑ W. Edwards Deming: Statistical adjustment of data. Wiley u. a., New York NY 1943, (Unabriged and corrected republication. Dover Publications, New York NY 1985, ISBN 0-486-64685-8).

- ↑ Paul Glaister: Least squares revisited. In: The Mathematical Gazette. Band 85, Nummer 502, 2001, S. 104–107, JSTOR:3620485.

- ↑ Derek York, Norman M. Evensen, Margarita López Martı́nez, Jonás De Basabe Delgado: Unified equations for the slope, intercept, and standard errors of the best straight line. In: American Journal of Physics. Band 72, 2004, S. 367–375, doi:10.1119/1.1632486.